quels sont les critères de comparaison pour trouver le bon LLM

by krabatak | Apr 6, 2024 | gpt, intelligence artificiellle, llm, relation clients, Voicebot

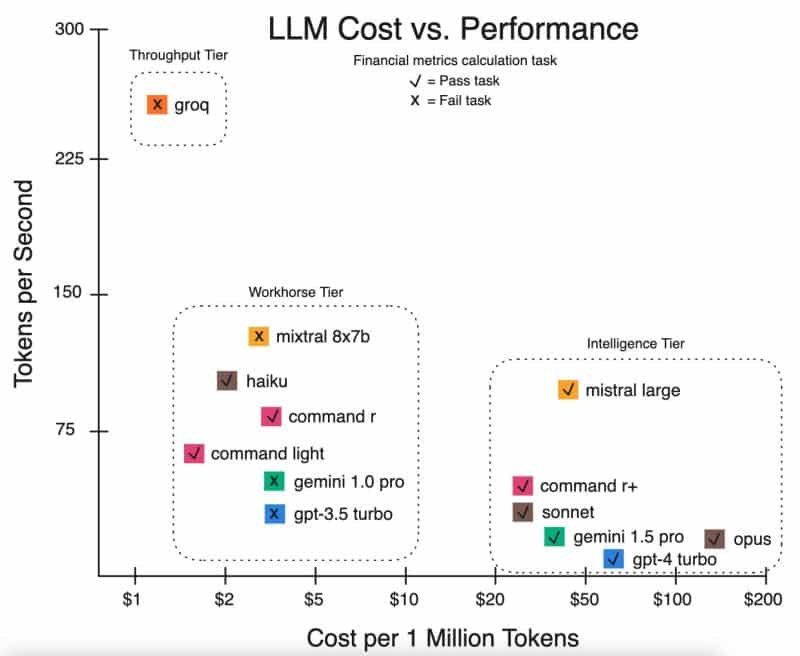

Dans le paysage actuel des modèles de langage de grande envergure (LLM), la sélection du modèle optimal pour une entreprise ne repose pas uniquement sur la performance en termes de compréhension du language et de génération de texte ou de chat. Il est essentiel d’établir un équilibre optimal entre trois piliers: la qualité de la réponse, le coût des tokens et la vitesse de réponse, formant ainsi un triptyque décisionnel.

Le graphique indique que Mistral se distingue par sa vitesse de traitement des tokens par seconde à un coût d’inférence comparable à celui des autres LLMs, ce qui en fait un concurrent sérieux dans la catégorie dite “Workhorse Tier”. Cela suggère que Mistral pourrait être un choix judicieux pour des tâches nécessitant rapidité et coût modéré sans compromettre excessivement la qualité de la réponse attendue.

Cependant, les modèles situés dans le “Intelligence Tier” comme Claude 3 Opus, GPT-4, et Gemini Pro 1.5, bien qu’affichant des coûts plus élevés et des vitesses de traitement moindres, suggèrent une capacité supérieure de compréhension et de création de contenu sophistiqué. Ces LLMs pourraient être privilégiés pour des applications où la nuance et la sophistication de la réponse sont critiques, justifiant ainsi leur coût supérieur. On parle bien de coûts démultipliés qui peuvent allourdir considérablement la facture.

La médiane recherchée est donc un compromis stratégique où chaque dimension est optimisée en fonction des besoins spécifiques de l’utilisation que l’on peut en faire. Dans le cadre du pré-entraînement, où les LLMs acquièrent des compétences linguistiques fondamentales, et de l’ajustement fin (fine tuning), qui affine ces compétences pour des applications spécifiques, une attention particulière doit être portée au coût d’inférence et à la vitesse, car ces phases peuvent s’avérer énergivores et coûteuses. Une moindre vitesse empêchera l’utilisation de ces technologies sur des callbots de TALKR car la vitesse de réponse en mars 2024 est est supérieure à 1 seconde sauf à condition de mettre le prix au niveau des puces Nvdia qui vont traiter les calculs.

Le choix d’un LLM et des IA Génératives ne doivent pas être dicté seulement par la performance seule, mais plutôt par une analyse approfondie du coût total de possession (TCO), qui englobe le coût initial de configuration, les coûts d’inférence, les coûts de maintenance, et les coûts associés. Une architecture hybride peut être envisagée, où des modèles plus rapides et moins coûteux sont utilisés pour des tâches courantes, tandis que des modèles plus coûteux et performants sont réservés à des tâches complexes. Sans parler aussi du problème lié au RGPD. Ou vont les datas ? que font les entreprises avec ces données. Cela ajoute alors une nouvelle dimension dans le choix final de l’outil que l’on va utiliser.

En outre, l’écosystème open source, avec des projets comme Llama, offre une alternative attractive, permettant aux entreprises de déployer des LLMs dans un cadre commercial sans les contraintes des solutions propriétaires, offrant ainsi une plus grande flexibilité et potentiellement des coûts réduits mais nos tests au seins de TALKR sont assez décevants en terme de qualité de réponse à moins de générer des prompts très longs : la longueur des prompts ajoute aussi alors une nouvelle dimension. Un mauvais LLM avec un bon prompt peut donner des résultats performants selon nos tests internes.

En tant que data scientist, l’analyse quantitative et qualitative de ces modèles nécessite une approche rigoureuse, intégrant des évaluations de performance (benchmarking), des analyses coût-bénéfice, et des considérations sur l’empreinte carbone associée aux opérations d’entraînement et d’inférence des modèles. La décision finale repose sur la synergie entre les exigences métier, l’expérience utilisateur et les contraintes budgétaires, orchestrées avec une compréhension approfondie des modèles LLM disponibles. C’est un véritable casse-tête !

Pour progresser dans cette légère analyse, il est impératif de se pencher sur la latence algorithmique, qui est souvent un compromis inévitable entre la vitesse d’exécution et la précision du modèle. La latence se manifeste par le délai entre la requête d’entrée et la réponse du système, ayant une incidence directe sur l’expérience utilisateur et la fluidité des interactions, particulièrement cruciales pour les applications en temps réel. Bien souvent mis à l’écart mais indispensable pour les outils conversationnels que nous développons au sein de notre entreprise.

Dans un contexte d’application, les modèles tels que Mistral et Gemini 1.0 Pro pourraient offrir un avantage opérationnel, du fait de leur efficience temporelle. Pour les applications nécessitant des interactions quasi instantanées, telles que les assistants virtuels ou les outils de support en direct, la minimisation de la latence est primordiale. L’inférence rapide permet de maintenir l’engagement de l’utilisateur et d’augmenter la satisfaction client, en dépit d’une légère dégradation de la qualité de réponse. Nous cherchons des outils capable de descendre en dessous de 500ms pour ne pas dégrader l’experience utilisateur.

Cependant, pour des applications exigeant un niveau élevé de sophistication, telles que les systèmes de recommandation ou l’analyse sémantique poussée, il est souvent préférable d’opter pour des modèles comme GPT-4 ou Opus, en dépit de leur coût plus élevé et de leur vitesse plus lente. Ces modèles avancés offrent une profondeur de compréhension et une créativité dans les réponses qui peuvent être déterminantes pour la valeur ajoutée du service ou du produit final. Ces modèles sont fortements plébiscité pour des tâches plus complexes. Cela devient d’autant plus intéressant qu’avec l’arrivée de GPT5 les anciens modèles devenant obselètes, les coûts des tokens vont s’éffondrer tout en conservant des qualités de réponses convenables avec des vitesse de traitement totalement abordable. Cela va donc avoir une incidence direct sur la propagation de bots vocaux partout dans le monde à des couts raisonnables.

Le coût de maintenance doit aussi être considéré, incluant les mises à jour des modèles et le monitoring continu des performances. Dans le cadre d’un modèle open source comme Llama, bien que l’absence de frais de licence soit attrayante, les coûts cachés liés à la maintenance, l’intégration continue, et la gestion des infrastructures doivent être évalués minutieusement.

il va de soit que nous devons envisager les coûts indirects associés, tels que ceux liés à l’empreinte écologique des infrastructures de calcul nécessaires à l’entraînement et au déploiement des LLMs. La consommation énergétique et les émissions de carbone associées aux data centers qui hébergent ces modèles ne sont pas négligeables et peuvent influencer la décision d’une entreprise soucieuse de sa responsabilité environnementale. Ce sujet reste sous jacent et pas encore tellement mis en avant malgré les politiques RSE des grandes entreprises qui n’ont pas encore pris conscience des dangers énergivores de ces modèles. En effet, la moindre requête consomme de l’énergie. il est donc important de savoir utiliser à bon escient, ces modèles dans les conversations, uniquement là ou on peut en avoir l’utilité.

L’adoption d’un LLM pour n’importe quelle organisation doit résulter d’une analyse multidimensionnelle et d’une compréhension approfondie du rapport “qualité-prix-vitesse-energie-sécurité“. L’architecture choisie doit être agile, évolutive, et adaptée aux besoins spécifiques, tout en étant éco-responsable. Les innovations dans l’optimisation des modèles et les nouvelles avancées en matière de réduction de la latence et du coût d’opération continueront de remodeler le paysage des LLMs, offrant ainsi aux entreprises des opportunités de rester compétitives dans un monde numérique en rapide mutation.